ABAP

Netweaver

物联网

ui

CANoe

单元测试

内网穿透

钉钉

sqlserver

仿真

最短路

Typora

图书馆座位预约

螺旋折线

位置编码

暴力

分布式存储技术

html静态页面

远程医疗

gunicorn

Qwen

2024/4/26 20:24:48Qwen-7B微调实例

Qwen-SFT

阿里通义千问(Qwen-7B-Chat/Qwen-7B), 微调/LORA/推理

Github

https://github.com/yongzhuo/Qwen-SFT

踩坑

1. tokenizer.encode输出(不会新增特殊字符), 为 [真实文本tokens]:

2. chat-PROMPT: <|im_start|>system\nYou are a helpful assistant.<|im…

(附数据集)基于lora参数微调Qwen1.8chat模型的实战教程

基于lora微调Qwen1.8chat的实战教程

日期:2024-3-16作者:小知运行环境:jupyterLab描述:基于lora参数微调Qwen1.8chat模型。 样例数据集

- qwen_chat.json(小份数据)

- chat.json(中份数据&…

RAG - QA + Qwen + dashscope

文章目录 一、关于项目二、准备1、安装依赖包2、准备数据集3、准备 API-Key 三、代码实现准备数据生成 embeddings检索方法问答 转载改编自:qwen_doc_search_QA_based_on_dashscope.ipynb https://github.com/modelscope/modelscope/blob/master/examples/pytorch/a…

GPT实战系列-LangChain实现简单链

GPT实战系列-LangChain实现简单链

LangChain

GPT实战系列-LangChain如何构建基通义千问的多工具链

GPT实战系列-构建多参数的自定义LangChain工具

GPT实战系列-通过Basetool构建自定义LangChain工具方法

GPT实战系列-一种构建LangChain自定义Tool工具的简单方法

GPT实战系…

GPT实战系列-实战Qwen在Cuda 12+24G部署方案

GPT实战系列-实战Qwen在Cuda1224G部署方案

ChatGLM4进行新闻发布,但还没有开源更新,在此之际,实战部署测试Qwen大模型。目前Qwen的口碑貌似还不错,测试显卡内存24G,毕竟有限,排除了Qwen14非量化方案Qwen-1…

【LLM】Qwen学习

安装依赖

pip install transformers4.32.0

pip install accelerate

pip install tiktoken

pip install einops

pip install transformers_stream_generator0.0.4

pip install scipy

pip install auto-gptq optimum使用

参见官方介绍

模型

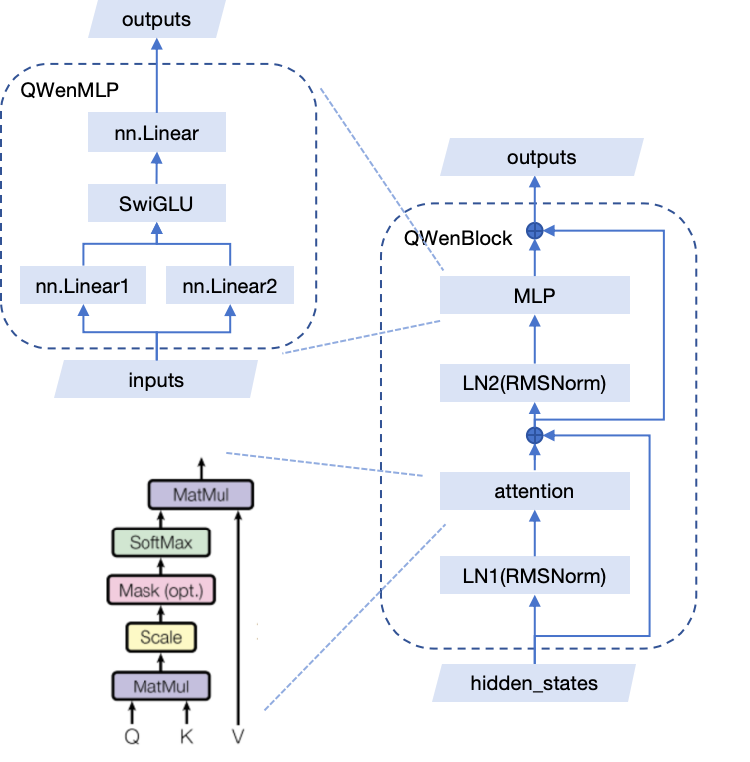

模型结构

QwenBlock 打印模型

##…

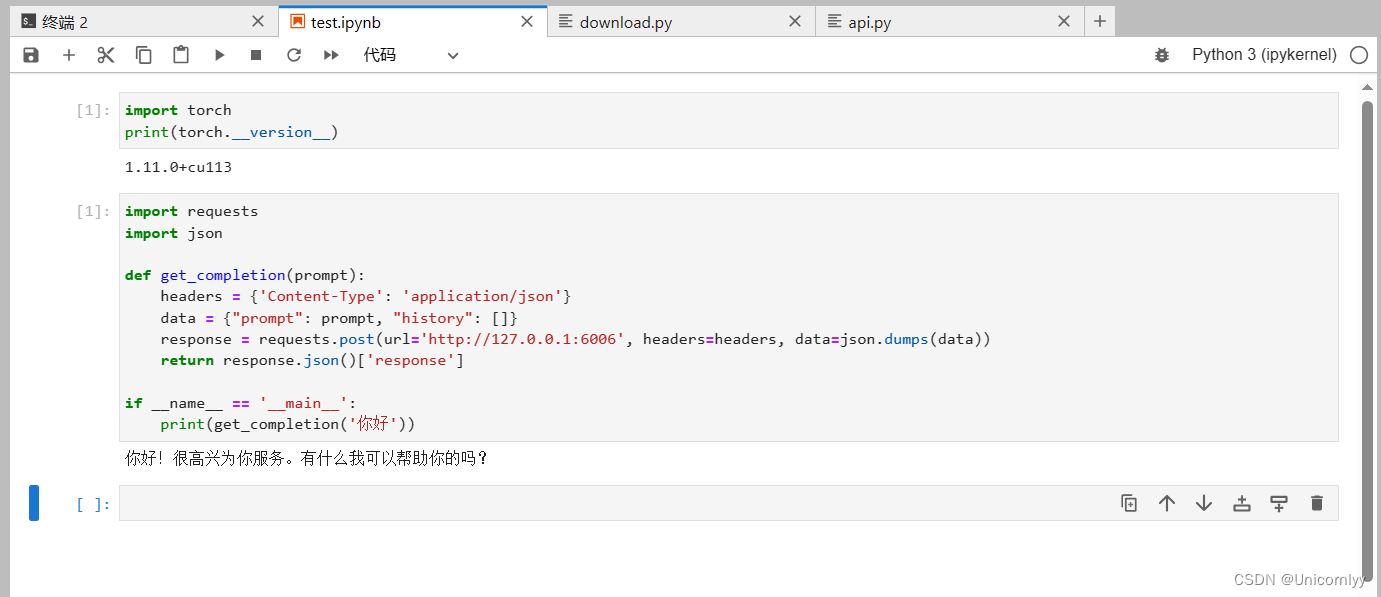

手把手教你Autodl平台Qwen-7B-Chat FastApi 部署调用

手把手带你在AutoDL上部署Qwen-7B-Chat FastApi 调用 项目地址:https://github.com/datawhalechina/self-llm.git 如果大家有其他模型想要部署教程,可以来仓库提交issue哦~ 也可以自己提交PR! 如果觉得仓库不错的话欢迎star!&…

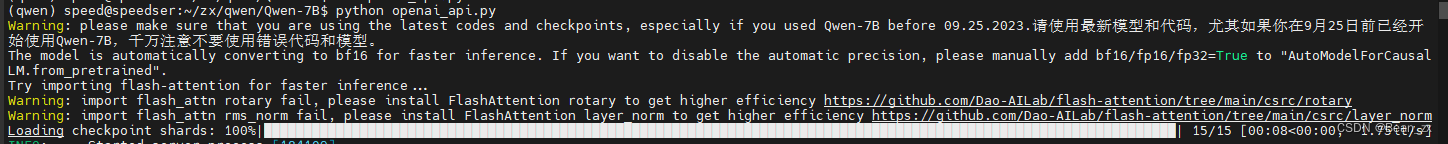

qwen大模型,推理速度慢,单卡/双卡速度慢,flash-attention安装,解决方案

场景

阿里的通义千问qwen大模型,推理速度慢,单卡/双卡速度慢。 详细: 1、今日在使用qwen-14b的float16版本进行推理(BF16/FP16) 1.1 在qwen-14b-int4也会有同样的现象 2、使用3090 24G显卡两张 3、模型加载的device是auto&#x…

【通义千问】大模型Qwen GitHub开源工程学习笔记(5)-- 模型的微调【全参数微调】【LoRA方法】【Q-LoRA方法】

摘要: 训练数据的准备

你需要将所有样本放到一个列表中并存入json文件中。每个样本对应一个字典,包含id和conversation,其中后者为一个列表。示例如下所示:

[{"id": "identity_0","conversations": [{"from": "user",…

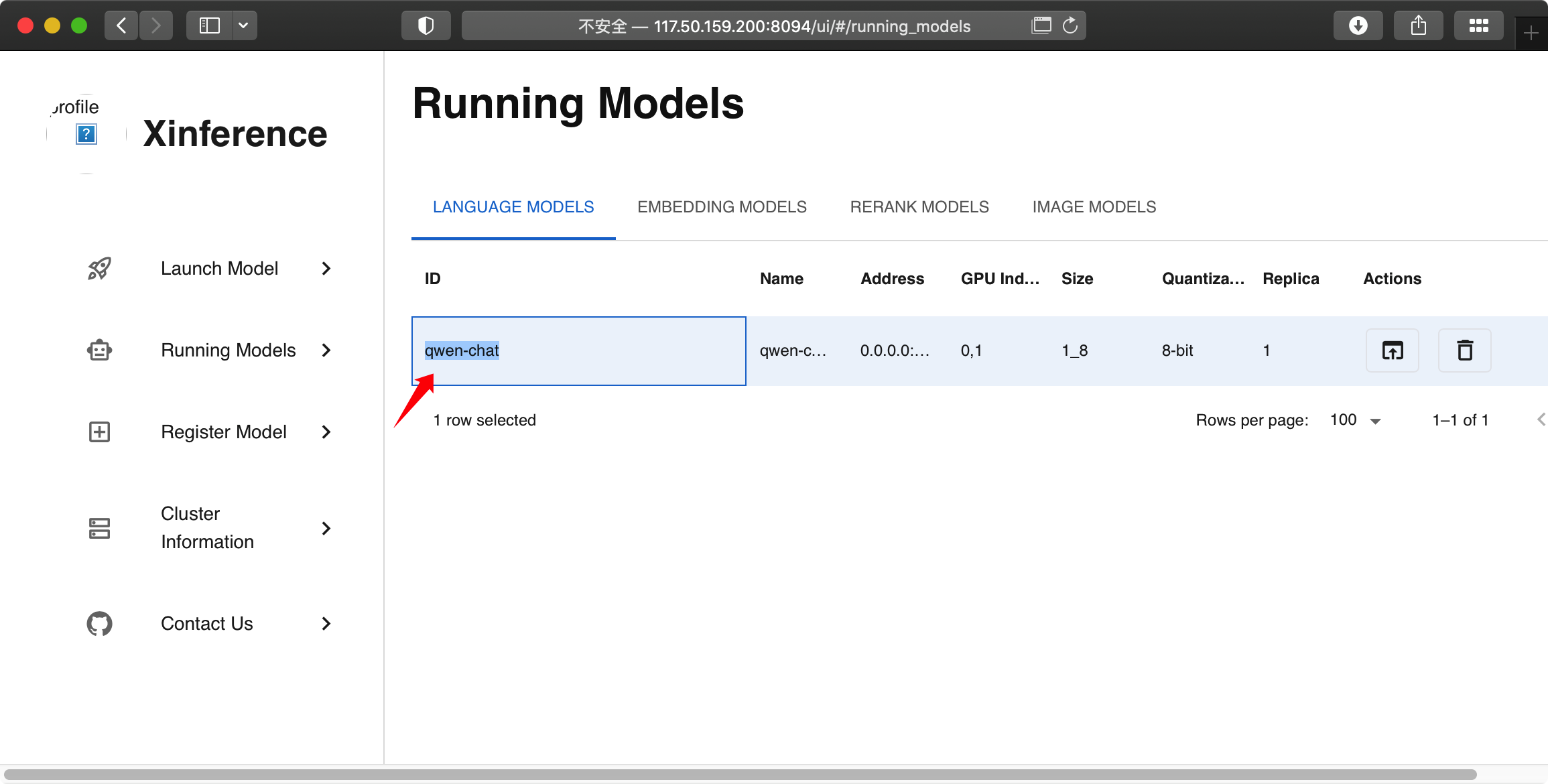

xinference - 大模型分布式推理框架

文章目录 关于 xinference使用1、启动 xinference设置其他参数 2、加载模型3、模型交互 其它报错处理 - transformer.wte.weight 关于 xinference

Xorbits Inference(Xinference)是一个性能强大且功能全面的分布式推理框架。 可用于大语言模型ÿ…

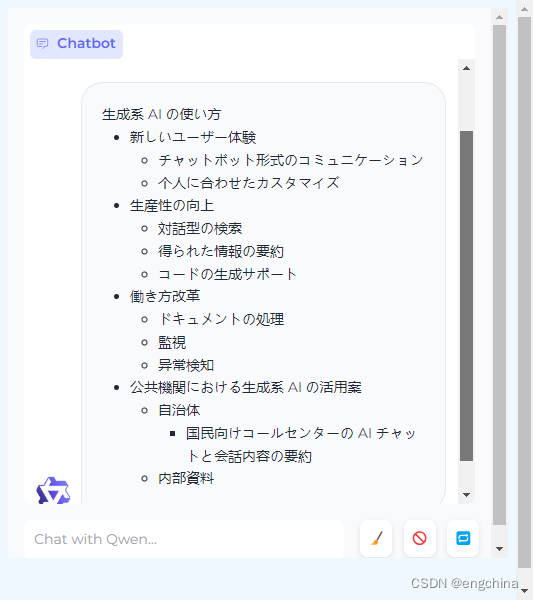

LangChain + Qwen(DashScope)

文章目录 引言DashScope API KEY关于 DashScope 和 ModelScope 代码可用模型及费用模型说明计费单价免费额度 引言

常见的 RAG 示例,一般使用 OpenAI,你也可以使用 Qwen 作为 LLM。 在 LangChain 中,调用 Tongyi 来实现。(而不是…

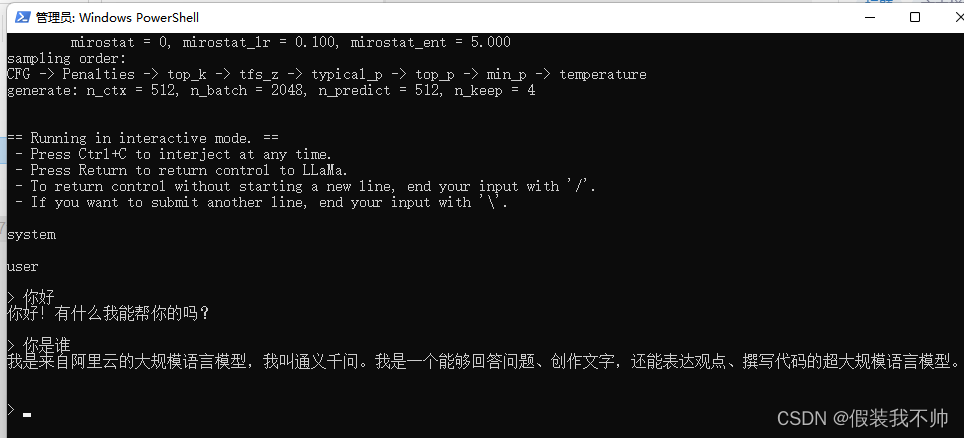

llama.cpp运行qwen0.5B

编译llama.cp

参考

下载模型

05b模型下载

转化模型

创建虚拟环境

conda create --prefixD:\miniconda3\envs\llamacpp python3.10

conda activate D:\miniconda3\envs\llamacpp安装所需要的包 cd G:\Cpp\llama.cpp-master

pip install -r requirements.txt

python conver…

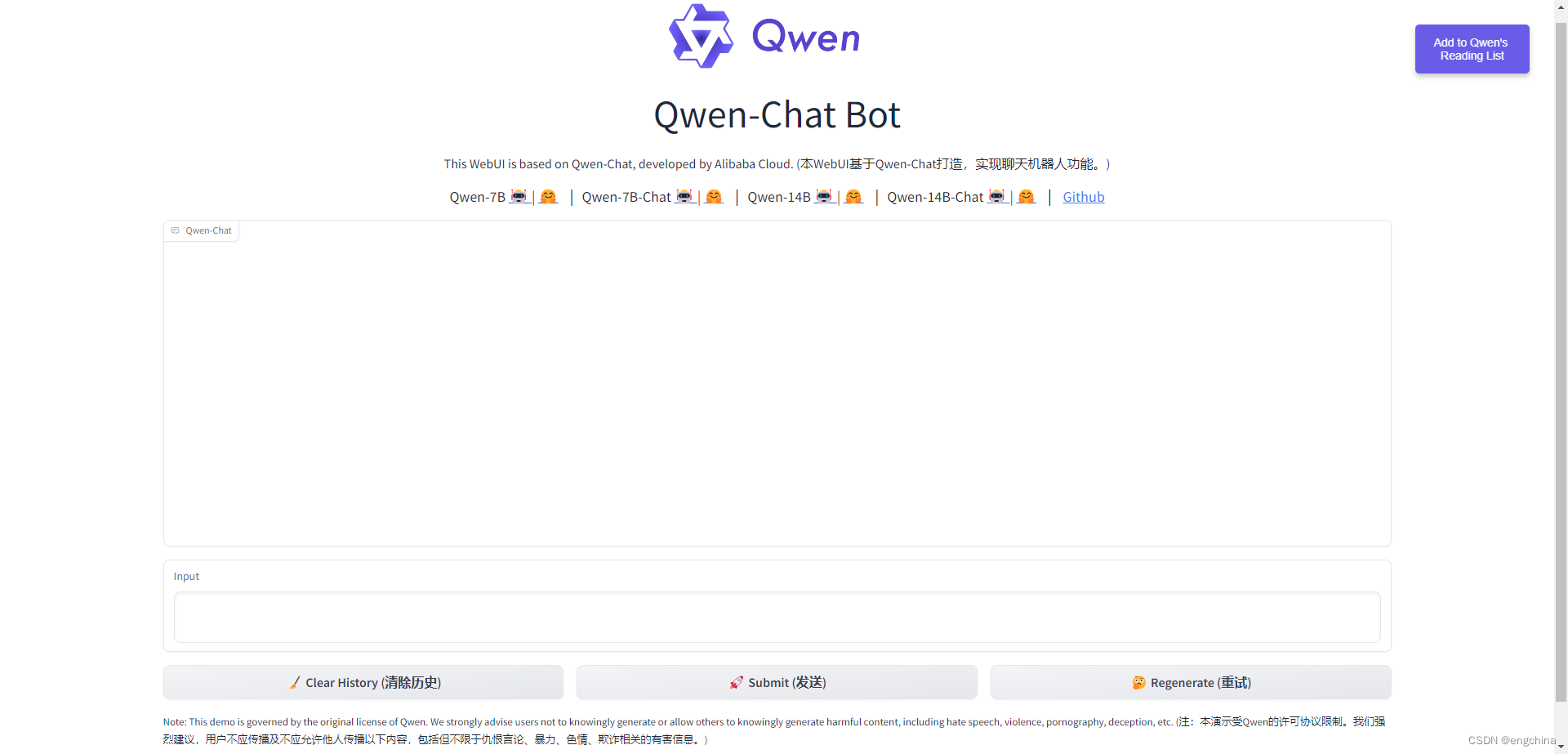

使用4090显卡部署 Qwen-14B-Chat-Int4

使用4090显卡部署 Qwen-14B-Chat-Int4 1. Qwen-Agent 概述2. Github 地址3. 创建虚拟环境4. 安装依赖项5. 快速使用6. 启动 web 演示7. 访问 Qwen 1. Qwen-Agent 概述

通义千问-14B(Qwen-14B) 是阿里云研发的通义千问大模型系列的140亿参数规模的模型。…

LLM端侧部署系列 | 如何将阿里千问大模型Qwen部署到手机上?实战演示(下篇)

引言 简介 编译Android可用的模型 转换权重 生成配置文件 模型编译 编译apk 修改配置文件 绑定android library 配置gradle 编译apk 手机上运行 安装 APK 植入模型 效果实测

0. 引言

清明时节雨纷纷,路上行人欲断魂。 小伙伴们好,我是《小…

qwen在vLLM下的长度外推简易方法

目的

在当前的版本vLLM中实现qwen的长度外推。

解决方法

在qwen的config.json中,增加如下内容: {"rope_scaling": { "type": "dynamic", "factor": 4.0}

}dynamic:动态NTK factor:缩放因子,外推长…

GPT实战系列-LangChain如何构建基通义千问的多工具链

GPT实战系列-LangChain如何构建基通义千问的多工具链

LLM大模型:

GPT实战系列-探究GPT等大模型的文本生成

GPT实战系列-Baichuan2等大模型的计算精度与量化

GPT实战系列-GPT训练的Pretraining,SFT,Reward Modeling,RLHF

GPT实…

本地部署 Qwen-Agent

本地部署 Qwen-Agent 1. Qwen-Agent 概述2. Github 地址3. 创建虚拟环境4. 安装 flash-attention5. 部署 Qwen 模型服务6. 部署 Qwen-Agent7. 浏览器访问 Qwen Agent8. 安装浏览器助手 1. Qwen-Agent 概述

Qwen-Agent 是一个代码框架,用于发掘开源通义千问模型&…

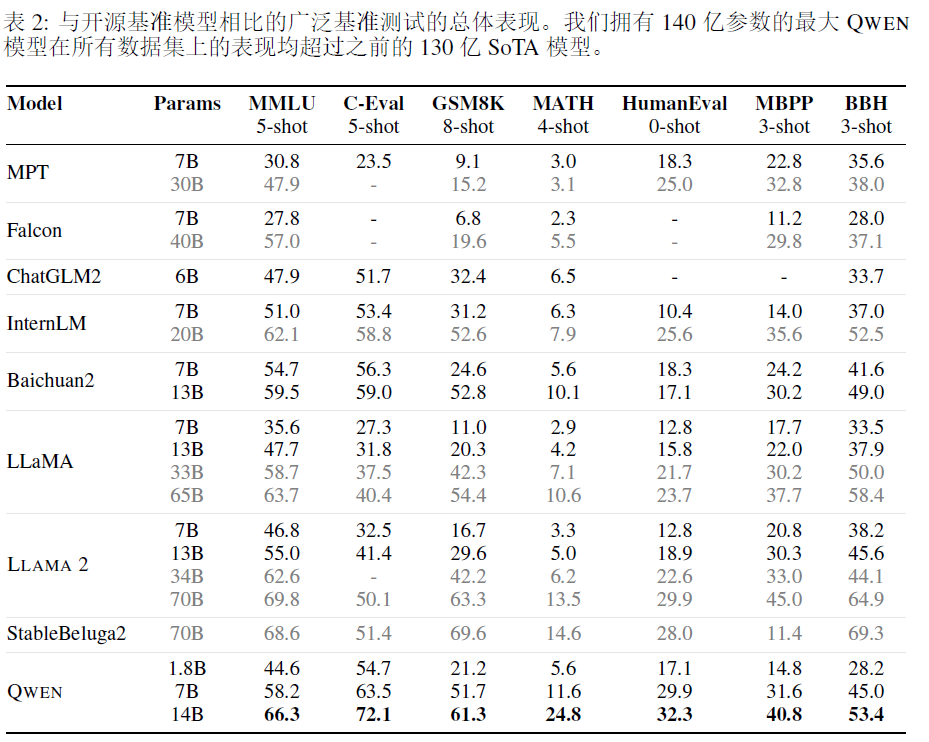

QWEN technical report

通义千问-Qwen技术报告细节分享 - 知乎写在前面大家好,我是刘聪NLP。 阿里在很早前就开源了Qwen-7B模型,但不知道为什么又下架了。就在昨天阿里又开源了Qwen-14B模型(原来的7B模型也放出来了),同时还放出了Qwen的技术报…